Generato con NotebookLM

CAPITOLO 1: Introduzione

ChatGPT in Azienda: Proteggi i Tuoi Dati Sensibili e Resta al Sicuro

Nell’era dell’intelligenza artificiale, strumenti come ChatGPT sembrano confidenti virtuali affidabili. Ma cosa succede quando condividiamo informazioni sensibili? Questo articolo esplora i rischi legati alla sicurezza dei dati e le migliori strategie per utilizzare l’AI in modo sicuro.

CAPITOLO 2: Perché la Protezione dei Dati è Cruciale

Evitare condivisioni involontarie e possibili abusi

Immagina di chiedere a ChatGPT un consiglio strategico o di condividere un codice aziendale per ottimizzarlo. Poco dopo, ti sorge un dubbio: le informazioni che hai fornito sono davvero al sicuro?

Molti modelli AI apprendono dai dati che ricevono e, sebbene OpenAI dichiari di non utilizzare le interazioni per addestrare ChatGPT (nella versione a pagamento), ogni informazione inviata potrebbe venire archiviata o analizzata. È dunque indispensabile capire come proteggere i propri dati e quali rischi si corrono.

Generata con ChatGPT-4o

CAPITOLO 3: I Rischi per le Aziende

Conseguenze pratiche di un uso incauto dell’AI

Le possibili implicazioni negative possono essere serie:

• Perdita di vantaggio competitivo, se una strategia innovativa diventa parte di un modello pubblico e, in futuro, accessibile indirettamente ad altri.

• Violazioni della privacy, soprattutto se si inseriscono dati personali di clienti o dipendenti, andando contro regolamenti come il GDPR.

• Esposizione di informazioni finanziarie, che potrebbero influenzare il mercato se diffuse in modo improprio.

Queste sono solo alcuni esempi delle possibili implicazioni negative. Essere consapevoli di tali rischi è il primo passo verso la protezione dei dati.

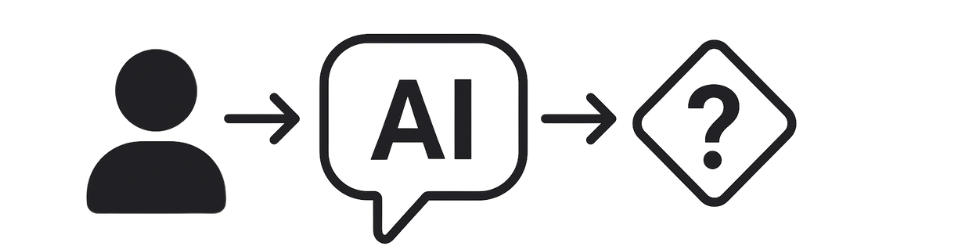

CAPITOLO 4: L’Illusione della Privacy

Perché interfacce user-friendly non garantiscono la riservatezza

L’esperienza fluida e “umana” di ChatGPT può trasmettere una falsa sensazione di sicurezza. In realtà, ogni informazione inserita può essere memorizzata, analizzata o riutilizzata (soprattutto in tool meno trasparenti). Per questo, è vitale adottare politiche di condivisione ben definite prima di fornire dettagli sensibili all’AI.

CAPITOLO 5: Esempi di Dati da NON Condividere

Tipologie di informazioni troppo delicate per l’IA

È essenziale tutelare:

• Dati personali (nome, indirizzo, telefono).

• Informazioni finanziarie e bancarie.

• Strategie aziendali riservate o codici sorgente proprietari.

• Dettagli su clienti, fornitori o dipendenti.

Meglio evitare completamente di inserirli in un modello AI pubblico o non controllato.

CAPITOLO 6: Definisci Linee Guida Aziendali

Il primo passo verso un uso sicuro di ChatGPT

Stabilisci regole chiare su cosa può essere comunicato all’AI. Forma i dipendenti, spiegando rischi e buone pratiche. Una policy interna ben scritta aiuta tutti a sapere fin dove ci si può spingere con la condivisione dei dati, evitando errori o leggerezze potenzialmente costose.

CAPITOLO 7: Usa Modelli On-Premise o Open Source

Evitare di inviare i propri dati a terzi

Se l’uso dell’AI è strategico, prendere in considerazione modelli open-source come LLaMA o Qwen e farli girare su server interni offre un controllo maggiore. In questo modo, non si condivide alcun dato con servizi esterni e si riduce la superficie di attacco per potenziali violazioni.

CAPITOLO 8: Sfrutta Framework e Agenti Personalizzati

Più controllo sui dati e minori rischi di esposizione

L’impiego di strumenti come Ollama o VLLM permette di eseguire modelli AI in locale, mantenendo la custodia totale delle informazioni. Esistono anche soluzioni per creare agenti AI su misura, in grado di interagire solo con i dati interni, senza inviarli a modelli pubblici. È un approccio sicuro che consente di sfruttare le potenzialità dell’AI senza compromettere la riservatezza.

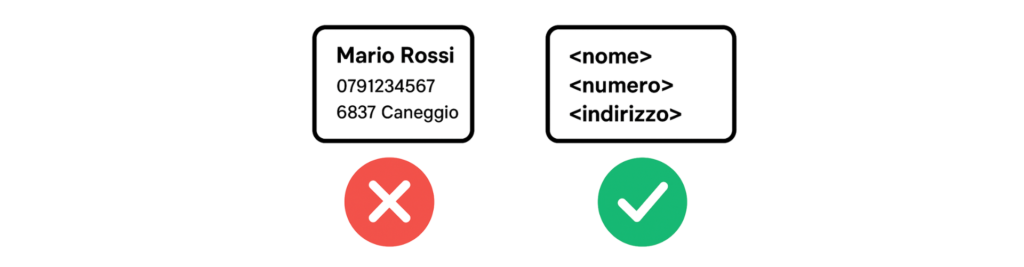

CAPITOLO 9: Anonimizza i Dati Quando Possibile

Impedire il riconoscimento di informazioni sensibili

Se devi testare una funzionalità o chiedere un parere su un codice, rimuovi dettagli sensibili o sostituiscili con placeholder (dati fittizi) prima di caricarli nel modello AI. In questo modo, eventuali “tracce” utili a risalire alle informazioni reali saranno neutralizzate.

CAPITOLO 10: Conclusione

Sicurezza e Innovazione possono coesistere

L’intelligenza artificiale offre opportunità eccezionali per le aziende, ma proteggere i dati deve rimanere una priorità. Con un approccio informato e adottando strategie mirate, si possono sfruttare i vantaggi dell’AI senza compromettere la sicurezza o la riservatezza delle informazioni aziendali.

Cosa ne pensi? Hai già messo in atto qualche misura per proteggere i dati quando usi l’AI? Condividi le tue esperienze: solo attraverso un uso consapevole e condiviso dell’AI potremo garantirci un futuro digitale sicuro e prospero.

Generato con Gamma.app